Фото: Apple

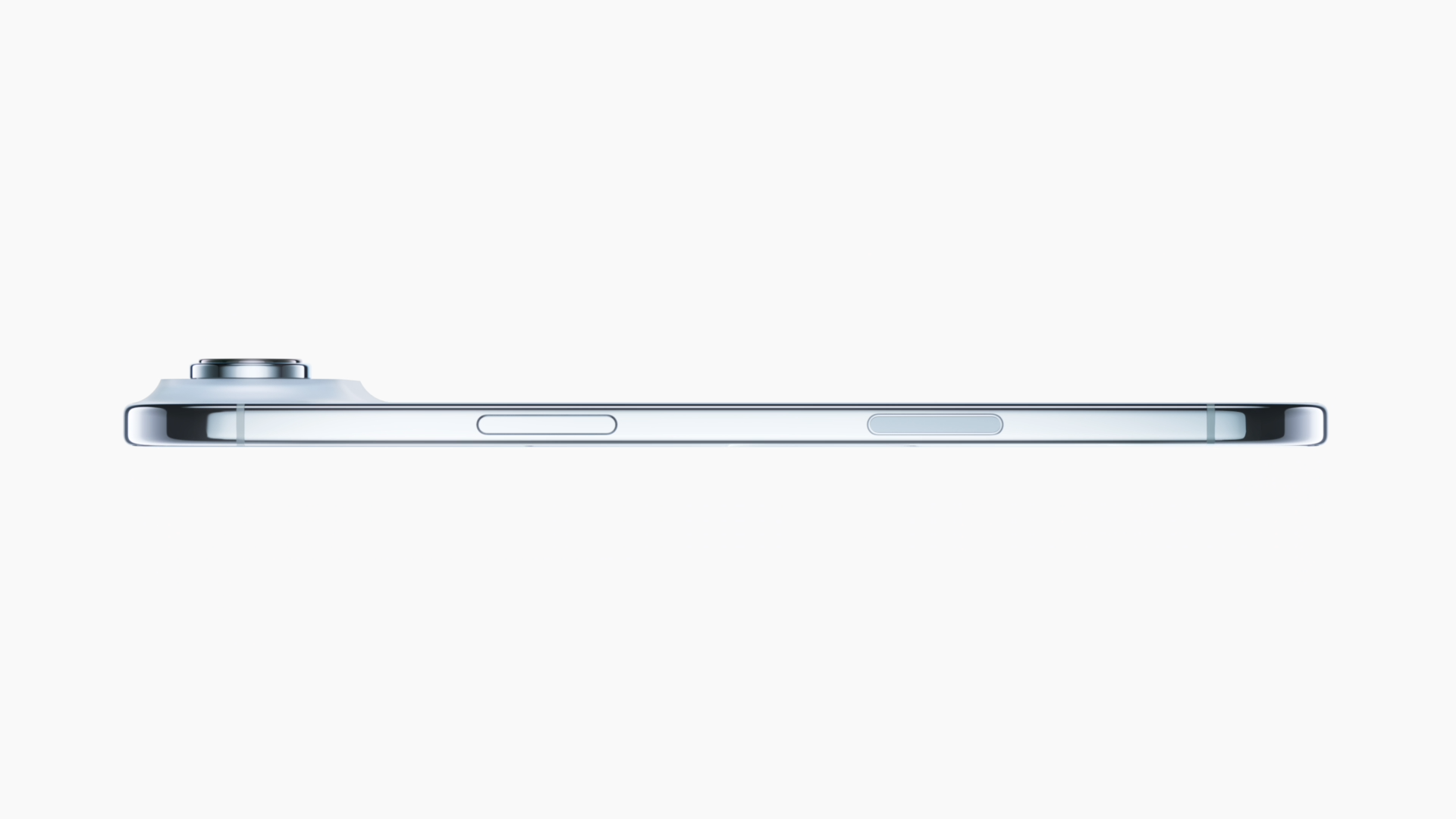

Компанія Apple офіційно анонсувала нову модель смартфона — iPhone Air, який став найтоншим в історії бренду (товщина лише 5,6 мм). Пристрій отримав титанову рамку, друге покоління Ceramic Shield та захист задньої панелі, що робить його найбільш витривалим iPhone.

Новинка оснащена 6,5-дюймовим Super Retina XDR-дисплеєм із технологією ProMotion (частота оновлення до 120 Гц) і піковою яскравістю до 3000 ніт.

Усередині — одразу три процесори:

- A19 Pro для продуктивності,

- N1 з підтримкою Wi-Fi 7 і Bluetooth 6,

- новий модем власної розробки Apple C1X, який удвічі швидший за попередній і на 30% енергоефективніший.

Основна камера на 48 МП Fusion підтримує додаткові фокусні відстані (28 мм та 35 мм), покращений нічний режим і 2х-телеоб’єктив. Фронтальна камера 18 МП Center Stage має квадратний сенсор, ширококутний огляд і функцію Dual Capture для одночасного запису з двох камер.

Apple підкреслює, що завдяки новій архітектурі та енергоефективним чипам iPhone Air забезпечує цілодобову автономність.

Модель буде доступна у кольорах Space Black, Cloud White, Light Gold та Sky Blue. Попередні замовлення стартують 12 вересня, а у продаж новинка надійде 19 вересня за ціною від $999.

Нагадаємо, Apple розглядає сторонні ШІ-моделі через втрату спеціалістів

Олена Стебніцька - pravdatutnews.com